版本:v1.0.8 大小:9.87MB 更新时间:2026-01-05T15:38:06 语言:中文 类型:便捷生活

标签:

软件简介

最近流行的人工智能AI助手——deepseek中文版,能让用户在线开展趣味十足的对话与问答;只需输入几个关键词和角色设定,它就能自动生成文章。这款软件支持多账号同时登录,所有记录和数据都会同步,有需要的用户可直接使用。

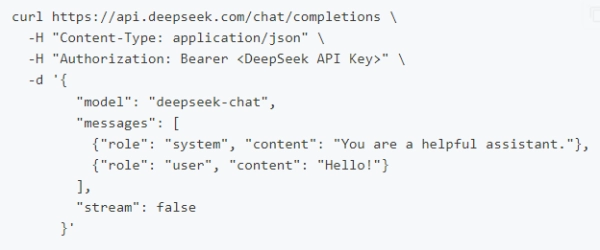

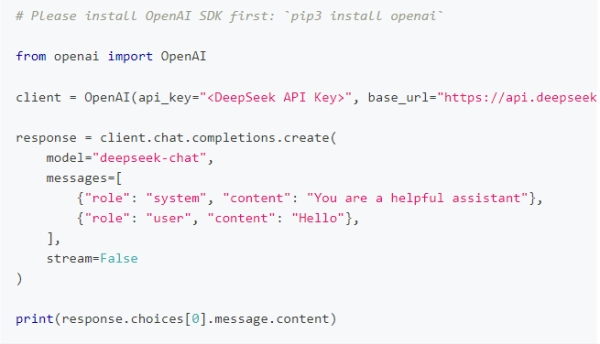

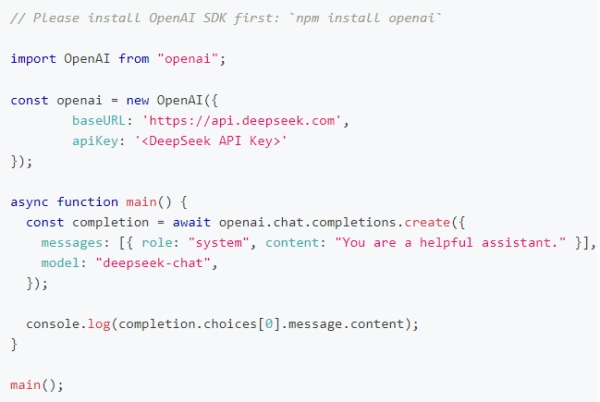

DeepSeek API 采用与 OpenAI 兼容的 API 格式,您只需调整配置,就能借助 OpenAI SDK 调用 DeepSeek API,也可以使用支持 OpenAI API 兼容的各类软件。

* 为了和 OpenAI 保持兼容,您也可以把 base_url 设为 https://api.deepseek.com/v1 来使用,不过要注意,这里的 v1 和模型版本没有关系。

deepseek-chat模型已完成全面升级,新版本为DeepSeek-V3,接口保持不变。用户只需指定model='deepseek-chat',就能调用DeepSeek-V3。

调用对话 API

在成功创建 API key 后,你能够借助以下示例脚本调用 DeepSeek API。该示例采用的是非流式输出方式,若需使用流式输出,只需将 stream 参数设置为 true 即可。

curl

python

nodejs

DeepSeek-V3 正式发布

今天(2026年12月26日),我们全新系列模型DeepSeek-V3的首个版本正式上线,并且同步完成了开源工作。

您只需登录chat.deepseek.com,就能与最新版的V3模型进行对话。API服务也已同步完成更新,接口配置方面无需进行任何改动。需要说明的是,当前版本的DeepSeek-V3暂时还不支持多模态的输入与输出功能。

性能对齐海外领军闭源模型

DeepSeek-V3 是我们自主研发的 MoE 模型,它拥有 6710 亿个参数,激活参数为 370 亿,并且是在 14.8 万亿个 token 的数据规模上完成预训练的。

论文链接:https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

DeepSeek-V3 在多项评测中的成绩优于 Qwen2.5-72B、Llama-3.1-405B 等其他开源模型,其性能与全球顶尖的闭源模型 GPT-4o、Claude-3.5-Sonnet 也不相上下。

● 百科知识:DeepSeek-V3 在知识类任务(MMLU、MMLU-Pro、GPQA、SimpleQA)上的表现较前代 DeepSeek-V2.5 有明显提升,已接近当前性能最优的模型 Claude-3.5-Sonnet-1022。

● 长文本:在长文本测评的DROP、FRAMES以及LongBench v2这几个基准上,DeepSeek-V3的平均表现优于其他对比模型。

● 代码表现:DeepSeek-V3 在算法类代码评测场景(Codeforces)中,性能显著超越当前市面上所有非 o1 类模型;而在工程类代码评测场景(SWE-Bench Verified)中,其表现已接近 Claude-3.5-Sonnet-1022。

● 数学领域:在2026年美国数学竞赛(AIME)和2026年全国高中数学联赛(CNMO)中,DeepSeek-V3 的表现显著超越了目前所有的开源及闭源模型。

● 中文能力方面:DeepSeek-V3和Qwen2.5-72B在教育类测评C-Eval以及代词消歧等评测集合上的表现不相上下,不过在事实知识类的C-SimpleQA评测中,DeepSeek-V3的表现更为突出。

生成速度提升至 3 倍

经过算法与工程层面的创新优化,DeepSeek-V3的生成吐字速度从20 TPS显著提升至60 TPS,较V2.5模型实现了3倍增长,让用户能够享受到更快捷流畅的使用体验。

开源权重和本地部署

DeepSeek-V3 运用 FP8 进行训练,并且开放了原生 FP8 权重的源代码。

借助开源社区的助力,SGLang与LMDeploy迅速实现了对V3模型原生FP8推理的支持,而TensorRT-LLM和MindIE也完成了BF16推理的适配。另外,为便于社区进行适配工作并拓展应用场景,我们还提供了FP8与BF16之间的转换脚本。

模型权重和更多本地部署信息请参考:

https://huggingface.co/deepseek-ai/DeepSeek-V3-Base

V3模型与R1系列模型均是在V3模型的基础版本V3-Base之上开发而来。和V3(类4o)模型相比,R1(类o1)系列模型在后续训练中引入了更多自我评估以及自我奖励形式的强化学习。

在R1问世以前,行业内的大模型大多依靠RLHF(基于人类反馈的强化学习)技术。这种强化学习方式会运用海量由人类编写的优质问答内容,以此让模型理解“怎样的答案才算优质”,从而帮助模型在奖励机制不清晰的情况下,学会应对复杂的选择。正是借助这项技术,GPT-3才得以升级为更具人性化的GPT-3.5,也正是它造就了2026年年末ChatGPT上线时带给人们的惊喜体验。然而,GPT后续发展陷入停滞,这也表明该模式已面临难以突破的瓶颈。

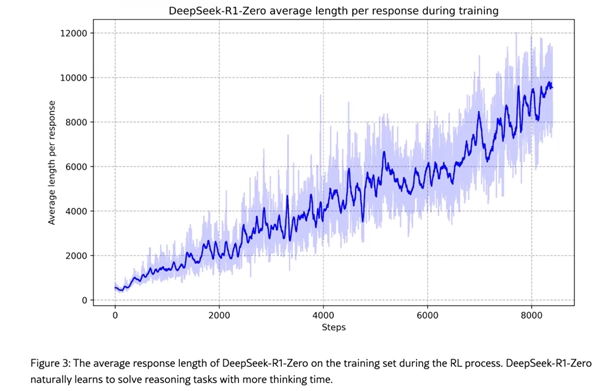

R1系列模型舍弃了RLHF中的HF(即人类反馈)环节,仅保留纯粹的强化学习机制。在初代产品R1-Zero中,深度求索(DeepSeek)采用了颇为大胆的强化学习流程:为模型配置两个奖励函数,其一针对“结果正确”的答案给予奖励(借助外部工具核验答案最终是否准确),其二则奖励“思考过程正确”的答案(通过一个小型验证模型来评估推理步骤的逻辑连贯性);同时鼓励模型一次生成多个不同答案,再依据这两个奖励函数对这些答案进行打分。

DeepSeek表示,其R系列模型在强化学习过程中展现出了「反思」能力。

DeepSeek团队观察到,从这一途径进入强化学习阶段的R1-Zero,初期生成的答案不仅可读性欠佳,语言表达上还频繁出现中英混杂的情况;不过,随着训练进程的推进,R1-Zero展现出持续的“自我迭代”能力,逐渐产生了像“反思”这类未被预先明确编程的复杂行为,并且会主动尝试探索解决问题的其他思路。

DeepSeek表示,这种被称为「啊哈时刻」的现象发生在模型训练进程的中期阶段。在这个阶段,DeepSeek-R1-Zero能够通过对自身初始方法的重新审视,学会合理分配更多的思考时长。「这一时刻恰恰体现了强化学习的强大与精妙之处——只要给予恰当的激励机制,模型便会主动探索并形成更高级的问题解决策略。」DeepSeek还提到,在经历了数千次这样的「纯强化学习」训练步骤后,DeepSeek-R1-Zero在推理类基准测试中的表现,已经可以与OpenAI-o1-0912的性能水平相媲美。

DeepSeek在论文中指出,「这是首个证实LLMs的推理能力能够单纯借助RL(强化学习)进行激发,而无需依赖SFT(supervised fine-tuning,即基于监督的微调)的开放研究。」

不过,纯强化学习训练存在一个问题:模型会过度关注答案是否正确,却忽略了语言流畅性这类基础能力,最终导致生成的文本出现中英混杂的情况。针对这一问题,DeepSeek额外加入了冷启动环节——先利用数千条包含规范语言表达和多步推理示例的链式思考(CoT)数据,对V3-Base模型进行微调,帮助模型初步具备逻辑连贯的生成能力;之后再启动强化学习流程,生成约60万个推理相关样本和约20万个非推理样本,将这总计80万个样本再次用于微调V3-Base模型,由此得到了R1。值得一提的是,DeepSeek还使用这80万条以思维链为核心的数据,对阿里巴巴的Qwen系列开源模型展开了微调,结果显示该系列模型的推理能力也得到了提升。

智能对话

高智商模型,顺滑对话体验

深度思考

先思考后回答,解决推理难题

AI 搜索

全网搜索,信息实时掌握

文件上传

阅读长文档,高效提取信息

精准翻译:为用户提供精准且流畅的翻译服务,助力其轻松适应多语言环境。

智能解题:攻克理科难题,给出详尽的解题思路与步骤,助力用户把握关键要点,实现深度理解。

文件解读:用户可以将文献书籍、资料报告等上传给DeepSeek,会帮助梳理重点,快速理解。

创意写作:能够依据指令自动产出富有创意的文案,完成各类文章与报告的撰写,迅速搭建内容框架,助力提升工作效率。

高效编程助力开发:兼容多类编程语言,可快速排查定位代码问题,自动生成所需代码片段,全方位提升编程开发的效率。

支持多语言及应用内语言选择。

支持应用内亮色/暗色模式切换。

支持深度思考与搜索同时开启。

软件信息

相关版本

同类推荐

专题推荐